22 juni sparkades ingenjören Blake Lemoine från Google. Lemoine hade knappt två veckor tidigare skapat rubriker världen över då han hävdade att LaMDA – Googles egen chatbot – hade tankar, känslor, och en själ. Ingenjören, som länge studerat medvetandefilosofins stora frågor, berättade att LaMDAs reflektioner i ämnet var mer sofistikerade än någon människa han talat med. I en tweet frågar han ”Vem är jag att bestämma var Gud kan och inte kan placera en själ?”

AI är föremål för våra mest blomstrande framtidsvisioner och värsta mardrömmar: en dubbel-eggad kniv, med kraften att antingen förgöra mänskligheten eller lösa alla hennes problem. För en filosof är AI såklart intressant av flera anledningar, även bortom denna utopi-dystopi-dikotomi. Liksom all transformativ teknologi genererar AI en uppsjö av etiska utmaningar som direkt berör våra liv. Hur och på vilket sätt påverkar AI – från rekommendationsalgoritmer i våra flöden till robotar i välfärden – vårt samhälle här idag; våra jobb, relationer, och sätt att förstå världen? AI skänker också nytt ljus på frågor som studerats i årtusenden, t ex. vad är en människa? Vad är medvetande, tänkande, moral, och autonomi? På vilket sätt kan en maskin materialisera eller gestalta dessa? Har vi skäl att ta Lemoine på allvar?

Vad som skiljer människan från andra djur, enligt Aristoteles, är hennes förnuft, vilket vi kan förstå som en förmåga att vara rationell i tanke och beteende. Genom sin utförliga undersökning av logiska slutledningar brukar även Aristoteles ses som den formella logikens fader. Under 1600-talet undersökte rationalister såsom Leibniz möjligheten att allt rationellt tänkande kunde systematiseras och behandlas lika metodiskt som algebra eller geometri. Leibniz föreställde sig ett universellt språk för resonemang, vilket skulle reducera argumentation till ren kalkylering; på så sätt skulle dispyter aldrig mer uppstå mellan två filosofer (låt oss kalkylera istället!).

Vad som förenar Aristoteles, Leibniz och moderna tänkare som Boole och Turing är att de alla hade idéer om hur tänkande kan formaliseras – och således automatiseras. Booles algebra av 1:or och 0:or kom att bli maskinernas språk och Turingmaskinen kom att bli dess teoretiska modell. Deras bidrag spelar en nyckelroll i utvecklingen av datamaskinen, och i synnerhet det som idag kallas symbolisk eller Good Old-Fashioned AI: tänkande som en stegvis process där logiska regler appliceras på symboler (som i sin tur representerar fakta eller premisser). Även om det under 1950-talet fanns otrolig optimism att Good Old-Fashioned AI skulle knäcka tänkandets nöt så stötte projektet på stora problem. Trots att datorerna kunde bevisa svåra teorem – som att t ex. grunda matematiska uttryck i symbolisk logik – kunde de inte lösa till synes enklare uppgifter så som att känna igen ansikten.

Parallellt löper berättelsen om en annan syn på tänkande – konnektionismen – som i stället för formella resonemang utgår från minne och inlärning. Vad som är intressant är att även denna syn kan härledas från Aristoteles, som hade teorin om att minne består av associationer – ”connections” – mellan mindre enheter som uppdateras via feedback. Idén fick stort stöd vid slutet av 1800-talet, då neurologisk forskning visade att hjärnan är ett nätverk av neuroner som kommunicerar via elektriska impulser. En slutgiltig pusselbit kom 1949, då Donald Hebb presenterade teorin om att nervcellers plasticitet är det som ligger till grund för inlärning hos människor. Tillsammans skulle dessa inspirera utvecklingen av artificiella neurala nätverk, som således försöker härma neurologin som återfinns i biologiska hjärnor. Även om idéer om artificiella neurala nätverk har florerat sedan 40-talet, så skulle det dröja till 2000-talet för dem att blomstra.

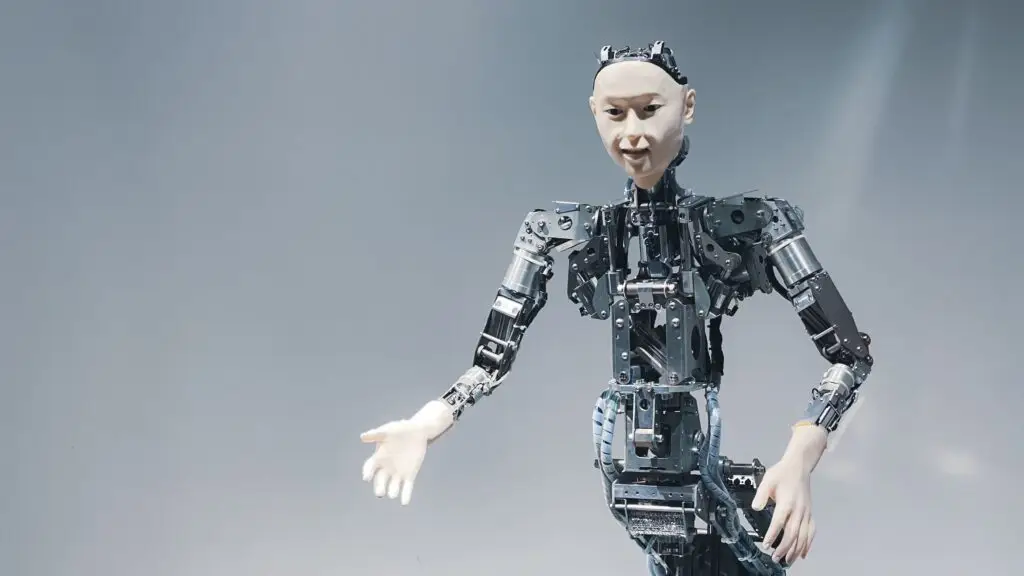

Den växande data- och tv-spelsindustrin drev på utvecklingen av grafik-processorer, som visade sig passa som handen i handsken för konnektionistisk inlärning: istället för att lösa ett problem i taget kan grafikprocessorer lösa många små problem parallellt. Idag har AI blivit mer eller mindre synonymt med maskininlärning då det är den teknik som fullständigt dominerar utvecklingen. Med hjälp av djupa neurala nätverk kan AI, utöver förmågan att känna igen ansikten, nå super-mänsklig prestanda i spel såsom Go och Starcraft 2, förutspå ett proteins struktur utifrån dess aminosyrasekvens, samt kontrollera magnetfält i en kärnfusionsreaktor. Det är även djupa neurala nätverk som ligger bakom de textgenererande AI-system som lyckats övertyga Lamoine och många andra om deras mänsklighet.

Fysikern Richard Feynman sa en gång ”Vad jag inte kan skapa kan jag inte förstå”. Detta ger en spännande hypotes: ett sätt att förstå människan är att skapa henne. Problemet med konnektionistisk AI tycks dock vara det omvända: det är något vi kan skapa, men inte enkelt förstå. Det funkar bra men vi vet inte riktigt varför. Medan symbolisk AI består av processer som liknar mänskliga resonemang (om än idealiserade), kan vi inte på samma sätt ha inblick i de ”svarta lådor” som djupa nätverk är (på samma sätt som vi inte kan läsa någons tankar genom att titta på hens hjärna). Det finns heller ingen ”gratis lunch” för maskininlärning: framgångsrik inlärning bygger på att man antingen har bra inlärningsexempel eller en koncis representation av problemet man vill lösa, vilket – cirkulärt nog – förutsätter att man redan vet vad man vill lära sig.

Detta återspeglar Humes induktionsproblem: finns det någon säker grund för den kunskap vi härlett från vår erfarenhet som inte i sig vilar på erfarenhet? Om vi accepterar Humes negativa svar på frågan – det finns inga icke-induktiva skäl för varför induktion funkar bra – så följer det att, även om inlärnings-AI kan lära sig vissa saker bättre än människor så är deras kunskap, liksom vår, aldrig perfekt. Det finns således inget bra svar på frågan ”hur många svanar måste en maskin observera för att sluta sig till att alla svanar är vita?” (kanske nästa vi ser är svart!). På samma sätt kan man tvivla på om det någonsin kommer finnas ett inlärnings-system som – i jobbrekrytering eller polisutredningar – aldrig diskriminerar mot en viss folkgrupp.

Andra problem handlar om mening och förståelse. Är meningen av ordet ”äpple” beroende av en abstrakt äpple-idé, eller är det endast återkommande mönster av ”äppelhet”? Searles ”kinesiska rum” är en klassisk variant: kan en maskin som lyckas övertyga en människa om att den förstår kinesiska genom att endast följa mekaniska regler verkligen förstå kinesiska? Vad blir svaret om den i stället, såsom LaMDA, lärt sig statistiska mönster utifrån människligt genererad text? Är man lika öppensinnad som Lamoine kan man säga: det spelar inte så stor roll vad som pågår ”inuti”, så länge maskinen, i alla väsentliga avseenden, beter sig som om den förstår kinesiska. Är man skeptisk som Searle kan man, å andra sidan, hävda att maskinen aldrig kommer att förstå, om inte förståelsen är grundad i ett medvetandes subjektiva erfarenhet (som såklart endast människor har!).

Poängen: det går en röd tråd genom antika idéer, vetenskapliga insikter, och modern AI-utveckling. Och då som idag är filosofer en central del av diskussionen. För att besvara Lamoine – liksom för att lyckas med det Feynmanska projektet – har vi god anledning att konfrontera dom nygamla frågorna. Och det är därför filosofer, vid sidan av ingenjörer och kognitionsforskare, bör tänka på artificiell intelligens.